AI決定には理解可能な説明が必要か?!

ドキュメンタリーで、アメリカのとある病院ではAIが臓器移植患者を決めるのと言う放送を見ました。移植後の生存確率などから割り出しているとのことでした。そこでは、移植を受けることができなかった方が悲嘆に暮れる様子が映し出されていました(その方より年配の方が移植を受けられました。)。「説明がなく割り出されて、納得できない。」と語っていた姿が心に残りました。

決定には説明がなされるべきであると考えます。我々の世界では、”こう考える”といった意見を述べるだけでも、常に確固とした情報に基づく根拠を示すことが求められるからです。いきなり結論が提示されても....論理的で感情を持ち合わせる人間には、AIの判断は理解不能です。ましてや、命の選別に対しては責任が求められべきです。

VOAで英語学びましょう!!

自分で説明するソフトウェアは本当に役に立つのか? (和訳)

Does Software that Explains Itself Really Help?

April 09,2022

人工知能(AI)システムを作る科学者たちは、ビジネス上の判断に適した予測を行うものを設計するのは問題ないと言います。しかし、そのようなツールを使う人々にとって効果的なものにするには、AIが別のアルゴリズムで自分自身を説明する必要があるかもしれないことが分かってきています。

AIはコンピュータサイエンスの一分野であり、機械に人間の知能のような能力を持たせることを目的としています。

"説明可能なAI"、すなわちXAIは、多くの投資を受けている新しい分野です。小さな新会社や大手テクノロジー企業が、複雑なソフトウェアをより理解しやすくするために競い合っています。米国や欧州連合の政府関係者も、機械の意思決定が公正で理解しやすいものになることを望んでいます。

専門家によると、AI技術は時として、社会における人種、性別、文化に関する不公平な意見を増加させる可能性があると言うのです。AI科学者の中には、説明はそれに対処するための重要な手段だと考える人もいます。

この2年間、米連邦取引委員会を含む米政府機関は、説明不可能なAIは調査される可能性があると警告してきました。欧州連合も来年、人工知能法を成立させる可能性があります。その法律では、AIの結果について説明を義務付けることになります。

説明可能なAIの支持者は、医療や営業といった分野でのAIの利用効果を高めるのに役立っていると言います。

例えば、マイクロソフトのプロフェッショナル・ネットワーク・サービス リンクトインは、営業チームにAIソフトを与えたところ、収入が8%増加しました。このソフトは、人が解約するリスクを予測することを目的としています。しかし、このソフトウェアは、なぜそのような予測をするのかという説明も提供します。

このシステムは昨年7月に発売されました。リンクトインのウェブサイトに記載される予定です。

しかし、AIによる予測の説明は信用できないという批判があります。機械の結果を説明するためのAI技術が不十分だと言います。

説明可能なAIの開発者たちは、プロセスの各段階を改善すべきだと言います。これらのステップには、予測の分析、説明の作成、確認、そしてユーザーの役に立つようにすることが含まれます。

しかし、2年後、LinkedIn社は、その技術はすでに価値を生み出していると述べています。その証拠に、今年度中にサブスクリプションの売り上げが8%増加したと言います。

AIソフトを導入する前は、LinkedInの営業担当者は自分の能力を駆使していました。今は、AIが素早く調査・分析をしてくれます。LinkedInではCrystalCandleと呼ばれ、行動を特定し、営業マンがサブスクリプションやその他のサービスを販売するのを支援しています。

LinkedInによると、説明ベースのサービスは5,000人以上の営業社員に広がっています。新しい働き手を見つけること、広告、マーケティング、教育提供などが含まれます。

「具体的な洞察で武装することで、経験豊富な営業マンを助けています。 」とパラベズ・アハマド氏は言います。彼はLinkedInの機械学習ディレクター兼データサイエンス応用研究責任者です。

しかし、AIの専門家の中には、説明が必要なのかどうか疑問視する人もいます。説明は、AIに安全という誤った考えを植え付け、害を及ぼす可能性さえあると言うのです。研究者たちは、有用性の低い設計変更を生み出す可能性もあると言います。

しかしLinkedInは、アルゴリズムの強さは、その "思考 "を理解しない限り、理解できないと述べています。

またLinkedInは、同社のCrystalCandleのようなツールは、他の分野のAIユーザーを助けることができるとも述べています。医師は、AIがある人の病気のリスクが高いと予測した理由を知ることができます。人々は、AIがクレジットカードの発行を拒否するよう勧めた理由を知ることができるでしょう。

ビーン・キム氏は、グーグルのAI研究者です。彼女は、説明によって、システムが人々が支持したいと思う考えや価値観を提示しているかどうかを示すことを期待しています。彼女は、説明は機械と人間の間に一種の議論を生み出すことができると述べています。

「人間と機械のコラボレーションを本当に可能にしたいのであれば、それが必要です。 」とキム氏は言います。

Does Software that Explains Itself Really Help?

Scientists who make artificial intelligence (AI) systems say they have no problem designing ones that make good predictions for business decisions. But they are finding that the AI may need to explain itself through another algorithm to make such tools effective for the people who use them.

AI is an area of computer science which aims to give machines abilities that seem like human intelligence.

“Explainable AI,” or XAI, is a new field that has received a lot of investment. Small, new companies and large technology companies are competing to make complex software more understandable. Government officials in the United States and European Union also want to make sure machines’ decision-making is fair and understandable.

Experts say that AI technology can sometimes increase unfair opinions about race, gender and culture in society. Some AI scientists think explanations are an important way to deal with that.

Over the last two years, U.S. government agencies including the Federal Trade Commission have warned that AI, which is not explainable, could be investigated. The European Union could also pass the Artificial Intelligence Act next year. That law would require explanations of AI results.

Supporters of explainable AI say it has helped increase the effectiveness of AI’s use in fields like healthcare and sales.

For example, Microsoft’s LinkedIn professional networking service earned 8 percent more money after giving its sales team AI software. The software aims to predict the risk of a person canceling a subscription. But the software also provides an explanation of why it makes a prediction.

The system was launched last July. It is expected to be described on LinkedIn’s website.

But critics say explanations of AI predictions are not trustworthy. They say the AI technology to explain the machines’ results is not good enough.

Developers of explainable AI say that each step in the process should be improved. These steps include analyzing predictions, creating explanations, confirming them and making them helpful for users.

But after two years, LinkedIn said its technology has already created value. It said the proof is the 8 percent increase in money from subscription sales during the current financial year.

Before the AI software, LinkedIn salespeople used their own abilities. Now, the AI quickly does research and analysis. Called CrystalCandle by LinkedIn, it identifies actions and helps salespeople sell subscriptions and other services.

LinkedIn said the explanation-based service has extended to more than 5,000 sales employees. It includes finding new workers, advertising, marketing and educational offerings.

"It has helped experienced salespeople by arming them with specific insights,” said Parvez Ahammad. He is LinkedIn's director of machine learning and head of data science applied research.

But some AI experts question whether explanations are needed. They say explanations could even do harm, creating a false idea of security in AI. Researchers say they could also create design changes that are less useful.

But LinkedIn said an algorithm's strength cannot be understood without understanding its “thinking.”

LinkedIn also said that tools like its CrystalCandle could help AI users in other fields. Doctors could learn why AI predicts that someone is more at risk of a disease. People could be told why AI recommended that they be denied a credit card.

Been Kim is an AI researcher at Google. She hopes that explanations show whether a system presents ideas and values people want to support. She said explanations can create a kind of discussion between machines and humans.

"If we truly want to enable human-machine collaboration, we need that,” Kim said.

Words in This Story

algorithm — n. a set of steps that are followed in order to solve a mathematical problem or to complete a computer process

subscription — n. an agreement that you make with a company to get a publication or service regularly and that you pay for regularly

gender — n. the state of being male or female

analyze –v. to study something closely and carefully; to learn the nature and relationship of the parts of something by a close and careful examination

insight — n. an understanding of the true nature of something

collaboration — n. to work with another person or group in order to gain or do something

Linkendln

下記リンクより抜粋

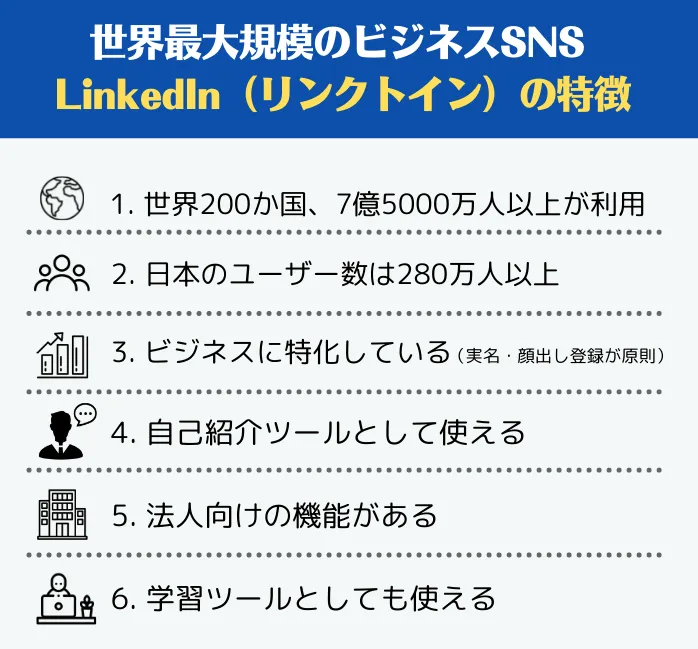

世界最大規模のビジネスSNSであるLinkedIn(リンクトイン)TwitterやFaceBookには及ばないものの、LinkedInの認知度は日本でも年々上がっており、実際、LinkedInは法人・個人ともに活用するメリットが多く、アクティブユーザーも増えている今、使わない手はないビジネスSNSです。

その特徴LinkedIn(リンクトイン)は2003年にリリースされたアメリカ発のビジネスSNSです。創業メンバーは氏らPaypalやSocialNetに在籍していたメンバー数名で、カリフォルニア州に本社が存在します。

アメリカをはじめとする欧米、東南アジア、そしてインドでも利用が盛んです。アメリカ:1億7000万人

ヨーロッパ:1億6000万人

インド :7000万人

海外ではfacebookは「プライベートSNS」として認識されており、ビジネスに関する発信はLinkedInで行う認識が一般的です。

仕事をする上で、LinkedInは名刺代わりに使われており、大学生でもLinkedInのアカウントを持って就活をしています。

現在の日本のLinkedInユーザー数は280万人以上と言われています。Twitterの日本のユーザー数は4500万人なので、比較するとまだまだ日本での認知度は低いですが、LinkedIn日本法人の活躍で着実にユーザー数は増えています。 LinkedInは、実名・顔出し登録が原則。ビジネスに特化したSNSであり、facebookのビジネス版と言われることが多いです。